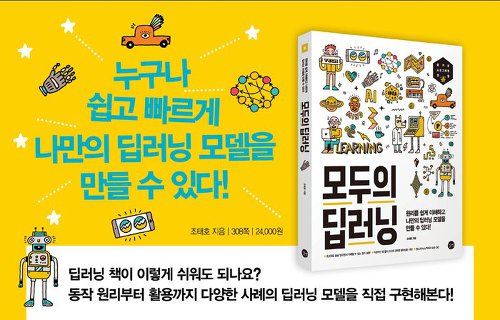

[해당 리뷰는 길벗출판사에서 서적을 지원받고 작성되었습니다.] 딥러닝의 처음을 함께 시작해줄 책 작업환경 설정부터 텐서플로우 기초까지,딥러닝 기초를 다지고 싶은 분 안녕하세요. 문범우입니다.이번에 소개해드리고자 하는 도서는 길벗출판사에서 출간한, '모두의 딥러닝'이라는 책 입니다. 최근에 개발자들 사이에서도 머신러닝, 딥러닝은 매우 중요하고 뜨거운 분야가 되고 있습니다.저도 아직 초보개발자이지만 딥러닝과 데이터분석에 대해서 공부하고자 이것저것 알아보며 학습중인데, 이러한 분들에게 매우 적극적으로 추천드리고 싶은 책입니다. '모두의 딥러닝'에서 제가 매력적으로 느낀 점들은 아래와 같습니다. 적당한 그림과 사진을 이용한 시각적 효과 보기 좋은 떡이 먹기도 좋다고 하잖아요? 저는 실제로 어떤 책을 고를 때 그..