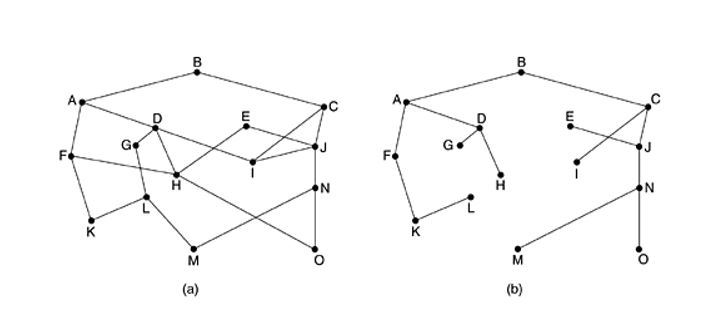

Routing Methodologies라우팅 알고리즘은 아래와 같이 존재합니다.Non-adaptive (static) algorithmShortest path routingFlooding: selective floodingFlow-based routing Adaptive (dynamic) algorithmDistance vector routingLink state routingHierarchical routing + Dijkstra algorithm 하나씩 알아보도록 하겠습니다. * Shortest path routing 그래프 이론에서 두 정점 간에 최단 경로를 찾는 그래프 알고리즘을 이용한 라우팅입니다. 출발지로부터 최단 경로를 갖는 점들을 차례대로 찾아가면서 경로를 탐색합니다. 그래프에서는 각 노드..